推理图-概念

type

status

date

slug

summary

tags

category

icon

password

网址

动机

机器学习推理系统正变得越来越庞大和复杂,它们通常由多个模型组合来完成单个预测。常见的应用场景包括图像分类和自然语言处理流水线。例如,人脸识别流水线可能需要首先在图像中定位人脸,然后计算人脸特征以匹配数据库中的记录。自然语言处理流水线则需要先进行文档分类,然后基于之前的分类结果执行下游的命名实体识别。

KServe在构建分布式推理图方面具有独特优势:自动扩缩的图路由器、与独立

InferenceServices的原生集成,以及用于模型链接的标准推理协议。KServe利用这些优势构建InferenceGraph,使用户能够以声明式和可扩展的方式将复杂的机器学习推理流水线部署到生产环境中。概念

- 推理图:由路由

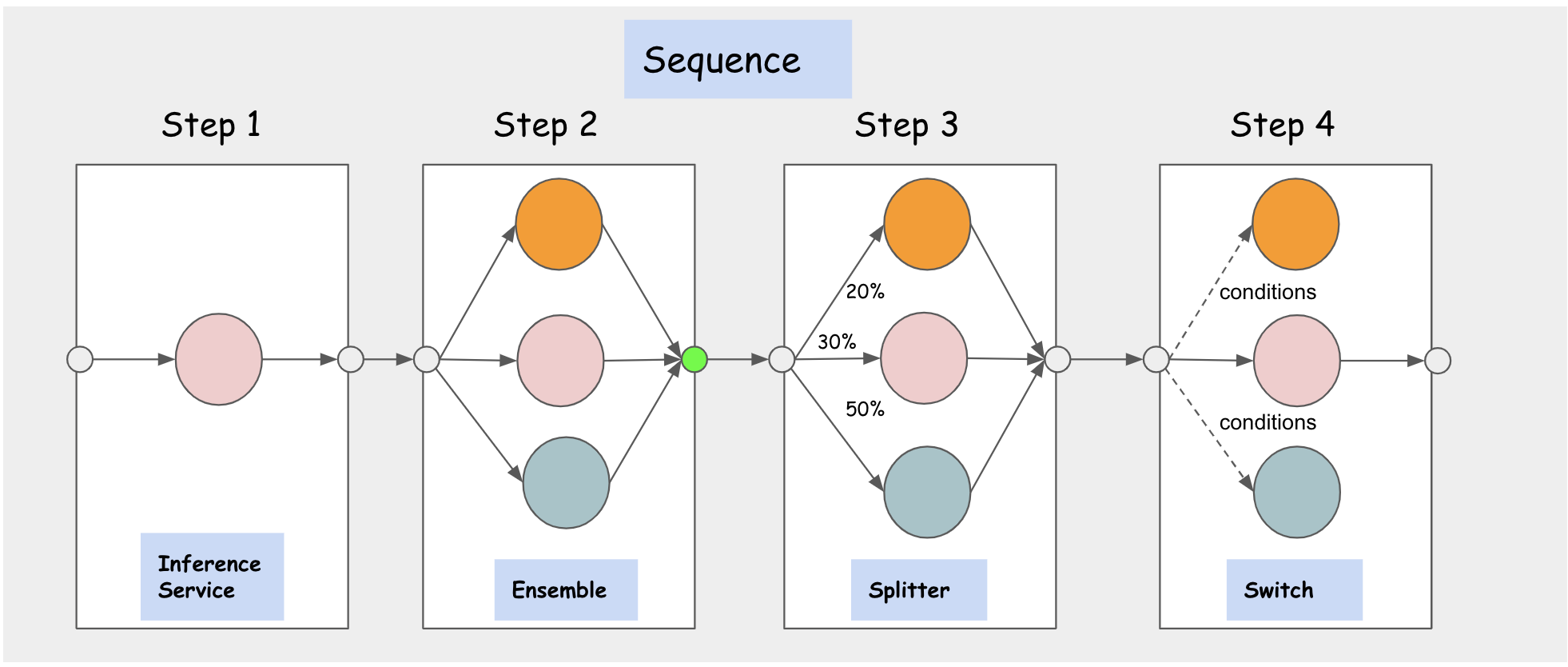

Nodes列表组成,每个Node包含一组路由Steps。每个Step可以路由到InferenceService或图中定义的另一个Node,这使得InferenceGraph具有高度的可组合性。图路由器部署在HTTP端点后面,可以根据请求量动态扩展。InferenceGraph支持四种不同类型的路由Nodes:序列、开关、集成、分流器。

- 序列节点:允许用户在序列中定义多个以

InferenceServices或Nodes为路由目标的Steps。这些Steps按顺序执行,前一步的请求/响应可以根据配置作为输入传递给下一步。

- 开关节点:使用户能够定义路由条件并选择满足条件时要执行的步骤。一旦找到匹配条件的第一个步骤,就会返回响应。如果没有匹配的条件,图会返回原始请求。

- 集成节点:模型集成需要分别对每个模型进行评分,然后将结果合并为单个预测响应。您可以使用不同的组合方法来生成最终结果。例如,多个分类树通常使用"多数投票"方法进行组合。多个回归树通常使用各种平均技术进行组合。

- 分流器节点:允许用户使用加权分布将流量分配到多个目标。

功能

请求头传播

如果您希望推理图的路由器将您在请求中传递给推理图的请求头传播到图中的所有步骤,您可以使用kserve命名空间中的

inferenceservice-config配置映射来实现。例如:如果您想传播某个请求头,比如"Custom-Header",那么您可以这样编辑inferenceservice-config配置映射的router部分:更新此配置映射后,kserve控制器将自动协调推理图以开始传播请求头。

上一篇

Transformer和Predictor的协同部署

下一篇

推理图-图像识别示例

Loading...